2. 淮阴工学院计算机与软件工程学院, 淮安, 223003

2. Faculty of Computer & Software Engineering, Huaiyin Institute of Technology, Huaian, 223003, China

基于视频的火焰检测已经成为火灾预防的一个非常重要的手段,火焰检测的算法研究成为了研究热点。Kosmas等[1]提出一种鲁棒性较高的火焰检测算法,以背景消减法结合颜色特征得到图像中火焰候选区域,然后采用不同的时空特征为火焰建模,同时基于线性动力系统(Linear dynamic systems, LDS)及其理论在每个候选区域中进行动态纹理分析,最后选用支持向量机(Support vector machine, SVM)进行训练分类。李正周等[2]提出一种无线传感网与人工神经网络结合的火灾检测与定位算法,根据训练与估计进行模糊推理决策。Kong等[3]提出一种可视化分析方法,通过背景消减法得到火焰的颜色大小及运动特征,使用逻辑回归(Logistic regression, LR)进行概率预测,并且用时间平滑降低敏感性以减少误检率。邵婧等[4]提出一种通过CCD摄像机获取火焰视频,建立LDS模型分析动态纹理特征,最后训练AdaBoost分类器判别火焰的方法。文献[5]提出一种分析帧间火焰低级特征的变化来描述火焰候选区域,并结合闪频及火焰的随机特征,输入到贝叶斯分类器中进行评估的算法。上述方法在检测火焰方面均取得了一定的效果,但同时也可以看出火焰的检测已经趋向于最终以分类器或者词典等训练识别,在没有大量训练样本的前提下检测与分类的准确率一般不太高。现在很多算法提取候选区域根据各类特征直接提取或者综合特征提取,在不能准确描述特征的前提下往往达不到良好的分割效果。Brian等[6]提出以超像素而不是以单个像素为单位来识别和定位目标。Yang等[7]提出一种基于超像素的外观鉴别模型,用中层信息跟踪识别目标与背景。宋熙煜等[8]基于各类超像素进行比较,从中得出简单的线性迭代聚类(Simple linear iterative c lustering,SLIC)超像素分割同时具备数量可控性与紧密度可控性,在边缘贴合度与紧密度之间取得了较好的平衡。

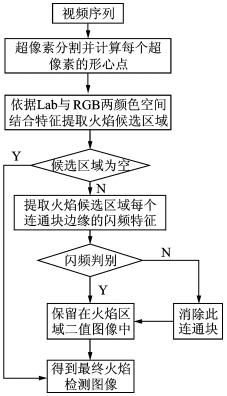

本文提出了一种基于SLIC超像素分割结合火焰的闪频特征识别的火焰检测算法,在Lab色彩模型中分割得到超像素,结合Lab与RGB两个色彩模型提取出包含火焰的超像素,最终以闪频特征识别其是否为火焰,解决了在训练样本不足的情况下分类器准确度不高的问题。本文方法在庭院火焰和森林火焰视频中均得到很好的识别效果,并且对于容易与火焰图像混淆的车辆图像也有较高的排除作用,检测率高,鲁棒性强。算法的总体流程如图 1所示。

|

图 1 算法总体流程 Fig. 1 Overall process of proposed algorithm |

1 SLIC超像素分割

SLIC是Achanta等[9]提出的一种聚类算法,该算法将彩色图像转换为CIELAB颜色空间和x-y坐标下的5维特征向量,对5维特征向量构造度量标准,然后对图像像素进行局部聚类。该算法过程简单,速度较快,能生成紧凑、近似均匀的超像素,在对视频火焰图像分割时, 设置参数少,轮廓保持完整,连通区域相对独立,适合于后续对分割图像特征的提取与判别。SLIC超像素分割方法算法如下:

Step 1 初始化种子点。首先在每一帧图像内均匀分配种子点,假定图片总共有N个像素点,预分割为n个超像素,则每个超像素所含像素N/n个,相邻的种子点间距离可以近似计算为S=sqrt(N/n)。

Step 2 微调种子点。为避免初始种子点落在图像轮廓边界或噪声点上,影响聚类效果,采用邻域内梯度最小化的方法,将种子点移到k×k邻域内像素梯度值最小点。梯度值定义如式(1)所示。

| $ G(x, y) = {\left[{v\left( {x + 1, y} \right)-v\left( {x-1, y} \right)} \right]^2} + {\rm{ }}{\left[{v\left( {x, y + 1} \right)-v\left( {x, y-1} \right)} \right]^2} $ | (1) |

Step 3 度量相似性。对于每个搜索到的像素点,分别计算它和该种子点的距离。距离计算方法如式(2)所示。

| $ \begin{array}{l} {d_{{\rm{lab}}}} = \sqrt {{{({l_j}-{l_i})}^2} + {{({a_j}-{a_i})}^2} + {{({b_j}-{b_i})}^2}} \\ {d_{xy}} = \sqrt {{{({x_j} - {x_i})}^2} + {{({y_j} - {y_i})}^2}} \\ {D_i} = {d_{{\rm{lab}}}} + \frac{m}{S}{d_{xy}} \end{array} $ | (2) |

式中:dlab代表两像素点的CIE -Lab模型的颜色距离,dxy代表其空间距离,S为聚类种子的间距,m为平衡参数,用来衡量颜色信息与空间信息的权重。最终得到相似度Di,其值越大表示两个像素间越相似。

Step 4 添加标签。每个像素点会被多个临近的种子点搜索到,取其点相似性最高的种子点作为聚类中心,添加其类标签。

Step 5 优化迭代。上述几个步骤不断迭代,直到聚类中心不再移动。

Step 6 提高连通性。聚类中心稳定后有可能出现某些小区域d归属某一个超像素却未与之连接的情况,这需要把区域d重新标志到与之连接的最大的超像素中,从而确保每个超像素的完整性。

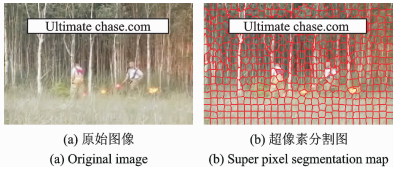

SLIC超像素分割算法在聚类过程中不像其他聚类是整体搜寻相似像素点,而是局部搜索,限定在以种子为中心的2S×2S的范围内,提高了算法的运行速度。图 2是本文火焰图像的超像素预分割效果图,由图 2(b)可以看出,火焰区域分割完整,边缘贴合度较好,根据实验时所得分割效果进行调整,参数选择为n=500,k=3,m=10。

|

图 2 火焰图像的超像素分割 Fig. 2 Super pixel segmentation of flame image |

2 超像素特征提取 2.1 Lab与RGB颜色空间

Lab颜色空间 [10]是一种描述人眼所能看到的所有颜色的颜色模型,由3个要素组成: L为亮度(Luminosity),a与b为色调。L的值域为[0, 100],0为黑色,100为白色;a的值域是-128, +128,-128为绿色,+128为洋红色;b的值域为[-128, +128],-128为蓝色,+128为黄色。L ab颜色空间比RGB颜色空间的色域更加宽阔,并且弥补了RGB色彩模型色彩分布不均的问题,表现的色彩与设备无关,更加贴近人眼感知到的色彩,因而在火焰的颜色特征方面,更加能够模拟人眼看到的特征从而达到分离提取的目的。

在火焰特征提取时,火焰部分的亮度一般很高,并且在人类视觉机制中,对亮度的敏感度大大高于色度。但传统提取中单一使用RGB颜色空间,会丢失掉亮度这一重要特征。本文在分析比较各种场景火焰的颜色参数中得出,Lab模型与RGB模型之间就红黄颜色和亮度存在一种互补的关系,并且Lab颜色空间中a和b的最高值颜色红与黄恰恰是火焰的最常见颜色,在阈值选取上更加准确易行,因此本文采用Lab与RGB颜色空间结合的方法来提取火焰颜色特征。从视频中读取到的帧信息均为RGB格式,需要进行格式转换,图像从RGB空间到Lab空间的转换过程如式(3)所示。在实验中,本文为了在亮度区分上更加细致和计算上更加简便,将L取值范围扩展为[0, 255],将a和b的值统一加128,取正值,取值范围为[0, 255]。

| $ \left\{ \begin{array}{l} L = 0.212\;6R + 0.712\;5G + 0.072\;2B\\ a = 1.463\;4 \times \left( {0.221\;3R-0.339\;0G + 0.011\;77B} \right) + 128\\ b = 0.619\;6 \times \left( {0.194\;9R + 0.605\;7G-1.800\;6B} \right) + 128 \end{array} \right. $ | (3) |

如图 2所示,超像素分割后得到预分割成的小区域,一个超像素区域内所有的像素点均极其相似,在微调种子点步骤中有效地避免了将聚类中心落在轮廓或者噪声点上,根据颜色距离与空间距离计算公式,离中心点越近的点就与聚类中心点相似性越大,就越能体现这个聚类的一般特征。所以本文选用二维图像的中心点, 即二维图形的形心点, 代表一个超像素区域的特征点,遍历整幅图像获得每个超像素形心点(x, y), 取其坐标上的L, a, b值。形心点(x, y)的计算如式(4)所示。

| $ \left\{ \begin{array}{l} x = \frac{{\sum {x_i}}}{N}\\ y = \frac{{\sum {y_i}}}{N} \end{array} \right.i = 1, \cdots, N $ | (4) |

式中N为超像素所包含的像素个数。

2.3 颜色特征提取在Lab颜色模型中,其a,b色度值的最高点为红与黄,正好为火焰的主要颜色,因此只需要选择下阈值,RGB颜色模型中火焰特征的蓝色分量B值都较低,红色分量R值均较高,两分量值差距较大,所以分别取其蓝色分量上阈值与红色分量下阈值。在特征提取时只需要掌控每个分量的单侧阈值,不仅降低了实验的难度,而且使提取的特征更加完整。基于以上特性及大量实验总结,本文提出如下提取规则:

Rule 1 L>LN, a>aN, b>bN;

Rule 2 B < BN, R>RN;

Rule 3 R-(G+B) < K或者G>B。

其中L,a,b分别为Lab颜色模型中亮度、色调三分量; R,G,B分别为RGB颜色模型中的红、绿、蓝三分量。

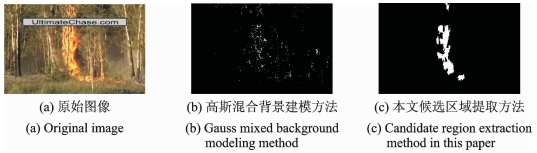

本文颜色特征提取过程中以Lab颜色空间为主、RGB空间辅助的原则进行选择,所以R, B两分量的阈值可以适当放宽,从互联网上选取1 0 00张左右各类火焰图片(图片无特定要求)进行实验分析,在RGB空间中总结火焰点像素规律,得到蓝色分量阈值BN=200,红色分量阈值RN=200,R, G, B三分量关系阈值K=20,如图 3所示,得到亮度阈值LN=130,绿至红色度阈值aN=90,蓝至黄色度阈值bN∈[155, 160]。图 4为实验对比结果,其中图 4(b)为高斯混合建模方法提取结果,这种方法在提取火焰前景时使用较多,从图中可以看出这种方法虽然能够提取到火焰前景,但其轮廓边缘模糊;图 4(c)为本文特征提取算法实验结果,提取规则中同时结合了RGB与Lab两个颜色模型的信息,通过颜色特征的预选,将大部分的干扰因素去除,提取的区域轮廓清晰、形状完整,更有利于后续的判别。

|

图 3 参数L, a, b的选择过程 Fig. 3 Parameter L, a, b selection process |

|

图 4 不同方法候选区域提取对比 Fig. 4 Comparison of candidate regions by two methods |

|

图 5 闪频对火焰候选区域的判别 Fig. 5 Identification of flame candidate region |

3 闪频特征提取与判别

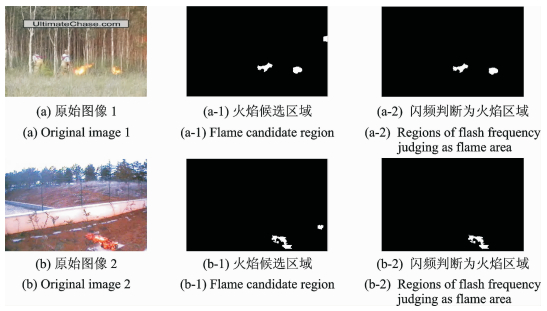

火焰特征分为静态特征与动态特征,颜色特征是静态特征中最为显著的特征,而在动态特征中,闪频则为火焰最明显的特征。火焰的闪烁频率主要分布在7~12 Hz之内,视频帧获取速率一般为25帧/s,因此每4帧图像至少得到一次闪烁,为防止视频中噪声带来的像素突变,本文选取10帧图像进行对比差分,得到的闪烁至少为2~3次。如图 5(a)中所示,图(a-1)中有3个候选连通区域,依次对其标记,按其标记顺序,使用边缘检测方法获取其边缘像素位置,总像素个数为N,按式(5)以差分的方法将边缘位置上的Lab信息与前9帧进行对比,累计其有变化的帧数。本文由火焰视频中观察分析得出,由于视频获取与传送的不稳定会造成不变像素间有1~2个值的变化,所以本文设定像素变化在2个值以上才认定为闪烁,变化阈值T=2。Lab(x, y)为像素(x, y)上的Lab信息。

| $ {T_n} = \frac{{\sum {\rm{if}}({\rm{Lab}}({x_i}, {y_i})-{\rm{Lab}}({x_{i-1}}, {y_{i{\rm{ }}-1}}) \ge T)}}{N} $ | (5) |

如式(6)所示,tmp为候选二值图像中的一个独立连通区域,闪频阈值TN∈[2, 3],最终保留tmp=1的独立连通域被判定为火焰图像。

| $ {\rm{tmp}} = \left\{ \begin{array}{l} 1\;\;{T_n} \ge {T_N}\\ 0\;\;{\rm{其他}} \end{array} \right. $ | (6) |

对图 5进行对比分析可以看出,图像中类似火焰区域会干扰候选区域的提取,本文算法通过闪频特征可以过滤掉非火焰区域,准确地保留火焰区域。因为算法中使用当前帧与前9帧差分对比的方法,所以在最初的9帧中火焰情况难以检测出,但是视频播放率平均25帧,9帧相对时间为0. 36s, 在现实中可以忽略不计。

4 实验结果与分析本文实验在Intel(R) i3 CPU 3.0 6 GHz 7.6 GB内存Windows 7系统Matlab 2013a环境下进行,实验中采用的火焰视频集和非火焰视频集均来自于Bilkent大学火焰视频库,该数据库是火焰检测领域目前公认的一个数据库,库内的火焰视频场景多样,库中的非火焰视频与火焰有较大的相似性,对比性较强。视频具体内容如表 1所示。

| 表 1 数据库视频集内容描述 Tab. 1 Database video content description |

本文实验与文献[11~13]进行对比。文献[11]利用高斯混合模型检测火焰前景,在大量森林火焰样本中提取颜色特征,最后检测到火焰。文献[12]中基于大量火焰图像提取得到颜色特征,通过累积的几何独立成分分析(Cumulative geometrical independent c omponent analysis, C-GICA)得到运动特征,最后运用反向传播(Back propaga tion,BP)神经网络识别火焰。文献[13]基于视觉显著性思想提取亮度与颜色特征,与局部二值模式组合提取纹理特征并选用主成分分析对其进行降维,用火焰颜色的累计差分表示动态特征,最终通过线性加权结合动静态特征。以上实验中均需要大量的实验样本,图片数量上万,对于样本的搜集与准备也需要花费大量时间,本文实验中的样本在千张图片以内,对图片质量无要求。

4.1 实验结果实验效果如图 6所示,实验结果如表 2,3所示。表 2中TP为火焰帧的准检率,FP为火焰帧的漏检率;表 3中TN为非火焰帧的准检率,FN为非火焰帧的误检率。

|

图 6 视频样本示例及检测效果 Fig. 6 Example of video samples and detection results |

| 表 2 火焰视频检测结果 Tab. 2 Flame videos detection results |

| 表 3 非火焰视频检测结果 Tab. 3 Non-flame videos detection results |

4.2 实验结果分析

图 6中视频1~6分别为选取的不同环境下的视频火焰场景,视频7, 8为易与火焰混淆的马路车灯场景。从图 6中可以看出,当算法检测到火焰时,以绿色标框标出,在无火焰时,视频帧中无任何表示。本文实验中,Lab空间的提取颜色特征偏黄与红,而车灯的颜色偏向白光带淡黄,所以在提取候选区域时已滤除大部分的车灯图像,在检测到有些颜色与火焰极为相似的车灯图像时,由于火焰具有闪频特征,而车灯不具备,最终能够在检测与识别中不受其影响。由表 2, 3结果对比分析,文献[11]利用高斯混合模型检测火焰前景,在大量森林火焰样本中提取颜色特征,最后检测到火焰,此算法主要针对森林火焰,所以对于森林火焰视频2, 3, 5中的检测效果较好。文献[12]的检测率较文献[11]有明显的提高,但是其通过BP神经网络训练闪频特征统计信息,在网络训练过程中,使用的网络参数不易调整到最佳值,并且其误差极易陷入局部极小,所以用此BP网络在检测如视频4一类的火焰时正检率不高,而在非火焰视频8中的误检率较高。文献[13]应用自上而下的注意模型,静态模型与动态模型以视觉注意机制结合,在火焰检测的具体检测中效果较文献[12]检测率高,但是因为使用视觉注意机制,所以在火焰前景与背景差别不明显时,检测率欠佳,如视频1与视频4。本文算法中,视频4与视频6的误检率较高,其原因是本文在候选区域提取时选用的是颜色特征,对于亮度高、色度鲜艳的图像帧较为敏感,在火焰颜色极不明显时,特征提取较为困难,视频4中色彩与背景墙的对比度不高,所以同比于其他视频的检测效果较差。但本文算法与文献[13]相比,准确率有了一定的提升,鲁棒性更好。

5 结束语本文提出了一种基于SLIC超像素分割结合闪频特征判别的视频火焰检测算法,基于视觉选择机制结合Lab颜色模型与RGB颜色模型,按照一定规则提取出颜色特征,其特征提取效果对于火焰颜色更为敏感。最后提取火焰动态闪频特征进行鉴别分类,这样节省了训练传统分类器所需要的大量样本与时间。本文算法的准确率较高,但是由于其需要前期的分割处理,以及需要在判别阶段提取视频的动态闪频特征,所以算法整体的运行时间较长,并且在某些色度较暗的火焰视频还有一定的提升空间。因此本文进一步的工作是发掘火焰的其他特征,减少对颜色特征的依赖,缩短动态特征提取时间,使算法的鲁棒性与实时性更好。

| [1] |

Kosmas D, Barmpoutis P, Grammalidis N. Spatio-temporal flame modeling and dynamic texture analysis for automatic video-based fire detection[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2015, 25(2): 339-351. DOI:10.1109/TCSVT.2014.2339592 |

| [2] |

李正周, 缪鹏飞, 刘勇, 等. 基于无线传感器网络的大型场所火情检测与定位算法[J]. 数据采集与处理, 2014, 29(6): 964-969. Li Zhengzhou, Miu Pengfei, Liu Yong, et al. Fire detection and position algorithm for large room based on wireless sensor network[J]. Journal of Data Acquisition and Processing, 2014, 29(6): 964-969. |

| [3] |

Kong S G, Jin D, Li S, et al. Fast fire flame detection in surveillance video using logistic regression and temporal smoothing[J]. Fire Safety Journal, 2016, 79: 37-43. DOI:10.1016/j.firesaf.2015.11.015 |

| [4] |

邵婧, 王冠香, 郭蔚. 基于视频动态纹理的火灾检测[J]. 中国图象图形学报, 2013, 18(6): 647-653. Shao Jing, Wang Guanxiang, Guo Wei. Fire detection based on video dynamic texture[J]. Journal of Image and Graphics, 2013, 18(6): 647-653. DOI:10.11834/jig.20130605 |

| [5] |

Borges P V K, Izquierdo E. A probabilistic approach for vision-based fire detection in videos[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2010, 20(5): 721-731. DOI:10.1109/TCSVT.2010.2045813 |

| [6] |

Fulkerson B, Vedaldi A, Soatto S. Class segmentation and object localization with superpixel neighborhoods[C]//IEEE 12th International Conference on Computer Vision(ICCV). Kyoto: IEEE, 2009: 670-677.

|

| [7] |

Yang F, Lu H, Yang M H. Robust superpixel tracking[J]. IEEE Transactions on Image Processing, 2014, 23(4): 1639-1651. DOI:10.1109/TIP.2014.2300823 |

| [8] |

宋熙煜, 周利莉, 李中国, 等. 图像分割中的超像素方法研究综述[J]. 中国图象图形学报, 2015, 20(5): 599-608. Song Xiyu, Zhou Lili, Li Zhongguo, et al. A review of the super pixel method in image segmentation[J]. Journal of Image and Graphics, 2015, 20(5): 599-608. DOI:10.11834/jig.20150502 |

| [9] |

Achanta R, Shaji A, Smith K, et al. SLIC superpixels compared to state-of-the-art superpixel methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2282. DOI:10.1109/TPAMI.2012.120 |

| [10] |

钱小燕, 韩磊, 王帮峰. 红外与可见光图像快速融合算法[J]. 计算机辅助设计与图形学学报, 2011, 23(7): 1211-1216. Qian Xiaoyan, Han Lei, Wang Bangfeng. Infrared and visible light image fast fusion algorithm[J]. Journal of Computer-Aided Design & Computer Graphics, 2011, 23(7): 1211-1216. |

| [11] |

Celik T, Demirel H. Fire detection in video sequences using a generic color model[J]. Fire Safety Journal, 2009, 44(2): 147-158. DOI:10.1016/j.firesaf.2008.05.005 |

| [12] |

Rong Jianzhong, Zhou Dechuang, Yao Wei, et al. Fire flame detection based on GICA and target tracking[J]. Optics & Laser Technology, 2013, 47(4): 283-291. |

| [13] |

杜静, 严云洋, 高尚兵, 等. 时空视觉选择性注意机制的视频火焰检测[J]. 计算机辅助设计与图形学学报, 2014, 26(3): 479-485. Du Jing, Yan Yunyang, Gao Shangbing, et al. Video flame detection[J]. Journal of Computer-Aided Design & Computer Graphics, 2014, 26(3): 479-485. |

2018, Vol. 33

2018, Vol. 33