2. 西安卫星测控中心, 西安, 710043;

3. 火箭军士官学校, 青州, 262500

2. Xi'an Statellite Control Center, Xi'an, 710043, China;

3. Rocket Sergeant School of PLA, Qingzhou, 262500, China

目标检测是计算机视觉的重要应用之一, 是后续目标识别、跟踪、目标分类以及行为分析的前提。远距离成像时通常会受到复杂变化的大气湍流影响, 使得成像结果中存在不规则抖动、偏移和模糊等退化现象[1, 2]。因此, 如何从湍流退化视频中提取出全部真实的运动目标, 同时尽可能降低湍流和噪声干扰导致的误检情况, 实现高精度、低误检率的目标检测技术研究具有重要的意义。

传统目标检测算法的基础可分为前景检测、帧间差分和背景减除3类。前景检测是通过对场景中运动矢量的分析得到运动的前景物体, 再辅以图像分析来获得运动目标。此类方法无需背景先验知识, 常用的有光流法[3, 4]、连续张量法[5]。其中, 光流法计算复杂且对光照变化敏感, 连续张量法提取快速运动的目标结果往往比实际大, 难以满足实际应用的要求。帧间差分法[6]采用相邻帧的对应像素相减来揭示连续帧的变化, 方法简单快速, 但由于帧差法不能有效记录背景的历史信息, 使得检测结果往往过于粗糙。背景减除法[7, 8]通过一定规则建立背景模型, 采用帧间相减和更新背景的方法获得检测结果, 其最具有代表性的是混合高斯模型法(Gaussians mixture model, GMM)[9]。该模型利用多个高斯模型描述像素点状态, 能够较好地适应场景变化。为改善场景变化(水面波动、树叶摇摆等)对检测效果的影响, 不少学者深入研究了GMM方法并提出了相应的改进方法[10, 11]。对于大气湍流条件下的视频, 其整个场景从单帧来看存在成像模糊和像素偏移, 从连续帧来看呈现出轻微抖动[12, 13]。这些因素会干扰场景中目标的运动检测, 导致单纯的前景检测或背景减除方法无法清晰地定位运动物体。传统的背景建模方法不能完美地描述湍流背景, 导致场景中物体识别十分困难。

近年来, 数据的低秩稀疏建模成为研究热点, 目前已被成功应用于语音增强[14]、立体重建[15]以及图像/视频恢复[16, 17]等。Oreifej等[18]通过寻找湍流图像中的低秩结构, 提出了一种低秩稀疏三分解的小目标检测法:首先计算图像中小区域内像素(如16×16)的运动轨迹, 再根据湍流和目标的运动分布不同, 设置目标置信度量, 引入低秩分解和稀疏建模思想, 将数据分为背景、湍流和小目标3部分。该方法对小目标检测精度非常高, 但用于非小目标检测时, 结果往往存在大量空洞, 且基于光流的粒子轨迹计算复杂、耗时久。本文以湍流条件下的红外视频为研究对象, 结合低秩分解和高斯建模思想及前景和背景检测, 提出了一种适应物体运动状态变化的目标检测算法, 提高了湍流退化条件下物体检测的精度, 在光照变化和模糊条件下仍能获得较好的检测结果。

1 基于低秩稀疏分解的湍流图像分解低秩稀疏分解模型(Low-rank and sparse decomposition, LRSD)考虑的是如何从较大但分布稀疏的误差中恢复出数据的低秩结构的问题, 其基本思想是将一个矩阵分解为一个低秩结构的低秩矩阵部分和一个随机分布的误差稀疏矩阵部分[19]。低秩分解模型符合现实中很多物理模型和现象, 相关理论也证明了模型求解的有效性。

对于湍流序列图像{I1, I2, …, In}, 图像分辨率为w×h, 将每帧图像排列为一个(w×h)×1列向量, 记为vec(Ii), i=1, …, N, 则整个序列组成的矩阵可表示为D={vec(I1), …, vec(In)}∈R(w×h)×n。相关研究指出, 大气湍流波动具有单峰性、对称性和局部重复性, 且湍流引起的序列局部像素偏移符合零均值高斯分布的特点[13, 18]。因此, 湍流分量可以采用Frobenius范数表示。湍流序列的低秩分解表示为

| $ \mathop {{\rm{min}}}\limits_{\mathit{\boldsymbol{A}}, \mathit{\boldsymbol{E}}} {\rm{rank}}\left( \mathit{\boldsymbol{A}} \right)\;\;\;\;\;\;\;{\rm{s}}{\rm{.t}}.\;\mathit{\boldsymbol{D}} = \mathit{\boldsymbol{A}} + \mathit{\boldsymbol{E}}, {\left\| \mathit{\boldsymbol{E}} \right\|_{\rm{F}}} \le \sigma $ | (1) |

式中:D, A, E分别表示观测的图像序列矩阵、低秩稳像矩阵和受湍流影响的稀疏矩阵。rank(A)表示矩阵A的秩。

| $ \mathop {{\rm{min}}}\limits_{\mathit{\boldsymbol{A}}, \mathit{\boldsymbol{E}}} {\rm{ }}{\left\| \mathit{\boldsymbol{A}} \right\|_*} + \gamma {\left\| \mathit{\boldsymbol{E}} \right\|_{\rm{F}}}^2\;\;{\rm{s}}{\rm{.t}}.\;\mathit{\boldsymbol{D}} = \mathit{\boldsymbol{A}} + \mathit{\boldsymbol{E}} $ | (2) |

式中:

在拉格朗日乘子算法的框架下, 式(2)可转化为

| $ \begin{array}{l} L\left( {\mathit{\boldsymbol{A}}, \mathit{\boldsymbol{E}}, \mathit{\boldsymbol{Y}}, \mu } \right) = {\left\| \mathit{\boldsymbol{A}} \right\|_*} + \gamma {\left\| \mathit{\boldsymbol{E}} \right\|_{\rm{F}}}^2 + {\rm{tr}}\left[{{\mathit{\boldsymbol{Y}}^{\rm{T}}}\left( {\mathit{\boldsymbol{D}}-\mathit{\boldsymbol{A}}-\mathit{\boldsymbol{E}}} \right)} \right] + \\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\frac{\mu }{2}{\left\| {\mathit{\boldsymbol{D}} -\mathit{\boldsymbol{A}} -\mathit{\boldsymbol{E}}} \right\|_{\rm{F}}}^2 \end{array} $ | (3) |

式中:Y∈ RM×T是拉格朗日乘子, tr(·)表示矩阵的迹。μ是惩罚因子, 通常设与输入数据维数逆相关, 设为μ=2 000/sqrt(size(D, 1))。目前已有一些算法实现了对式(3)的求解, 如加速近似梯度法(Ac-celerated proximal gradient, APG), Bregman迭代算法、精确增广拉格朗日乘子法(Augmented Lagrange multiple, ALM)和非精确增广拉格朗日乘子算法(Inexact augmented Lagrange multiple, IALM)等。

为了提高优化速度, 在前期研究的基础上, 本文采用IALM法来实现对式(3)的求解, 具体步骤见文献[20]。求解时间主要消耗在低秩部分A的迭代更新上, 通过奇异值截取算法求得解析解, 其时间复杂度最小为O(rA3), rA为A的秩。

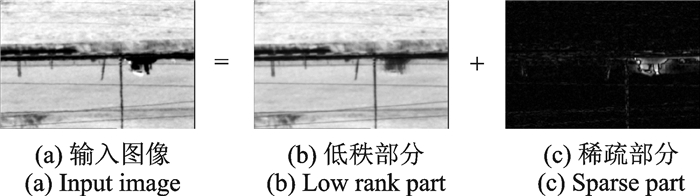

2 前景提取和背景建模结合的目标检测经过分解, 获得低秩稳像部分和稀疏运动部分如图 1所示, 稳像部分主要包括背景和部分运动目标像素, 稀疏部分为受湍流影响的运动像素和随机噪声。为了准确定位运动目标, 则需采用不同方法分别对两部分进行检测。

|

图 1 湍流退化视频帧的低秩分解 Fig. 1 Low-rank decomposition for turbulence-degraded frames |

2.1 基于自适应阈值的稀疏目标提取

对于每帧的稀疏部分(记为pi)采用自适应阈值分割图像, 以剔除细微偏移量和噪声的干扰。阈值Ti与稀疏部分的灰度均值有关, 设为

| $ {T_i} = {\rm{max}}(\alpha {\rm{median}}({p_i}), \varepsilon ) $ | (4) |

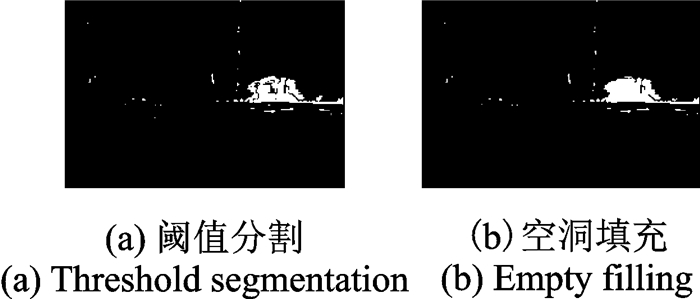

式中:median(·)为向量均值函数, α和ε为常量。每帧稀疏部分的像素值大于阈值为前景。稀疏块分割后的前景目标区域会在一定程度上存在内部空洞, 即目标区域的提取有漏检现象。鉴于此, 需进一步对提取出标定为前景运动目标的稀疏块掩模区域进行空洞检测和填充。

由于稀疏块掩模为二值型数据, 对于目标区域内的空洞可以通过8连通区域检测; 然后填充空洞区域以恢复目标区域的掩模, 以完成提取完整运动目标的效果。整个提取过程如图 2所示, 可以看出填充后丢失的目标域得到了较好的修复。

|

图 2 稀疏部分的目标提取 Fig. 2 Object detection of sparse matrix |

2.2 基于高斯模型的前景提取

在背景减除法中, 选择合适的背景模型和更新策略对检测的影响十分重要。其中, 混合高斯模型能够处理动态背景的情况, 但是计算量大, 实时性较差; 单高斯模型计算量小, 实时性好。考虑到低秩部分以静态场景为主, 局部区域可能存在动态量, 因此采用混合高斯模型和单高斯模型结合的方法对低秩部分进行目标检测。

2.2.1 混合高斯背景模型K个高斯分布生成背景模型, 将每帧新的像素值It(x, y)与K个分布依次进行匹配。若满足式(5)中条件, 说明与第i个分布匹配, 被认定为背景点, 否则认定为前景点。第t帧中像素点(x, y)为前景的布尔值记为fGMM(x, y, t), 有

| $ {f_{{\rm{GMM}}}}\left( {x, y, t} \right) = \left\{ \begin{array}{l} 1\;\;\;\;\;\left| {{I_t}\left( {x, y} \right)-{\mu _{i, t}}} \right|-2.5\cdot{\sigma _{i, t}} > 0\\ 0\;\;\;\;\;\;{其他}\; \end{array} \right. $ | (5) |

其中μi, t, σi, t分别是第i个高斯分布的均值和标准差。

2.2.2 单高斯前景模型受亮度变化干扰, 混合高斯检测结果中可能存在伪前景, 单高斯前景模型则用来区分静态前景和伪前景。将该区域的像素点与单高斯模型匹配, 若满足阈值则判定该点为静态前景点, 记为fstatic。若不满足则亦判定为干扰部分。即

| $ {f_{{\rm{static}}}}\left( {x, y, t} \right) = \left\{ \begin{array}{l} 1\;\;\;\;\;\;\;\;\left| {{I_t}\left( {x, y} \right)-{\mu _t}} \right|/{\sigma _t} > {T_f}\\ 0\;\;\;\;\;\;\;{其他} \end{array} \right. $ | (6) |

式中:μt, σt分别为当前高斯分布的均值和标准差, Tf为前景阈值。

2.2.3 模型初始化和更新策略利用初始一段时间内视频帧的低秩部分, 建立高斯数为K的混合高斯背景模型。同时初始化前景模型为空。更新时, 采用保守更新策略, 即混合高斯分布的参数更新时仅涉及背景区域像素, 有

| $ {\mu _t} = \left( {1-\alpha } \right)M{\mu _{t-1}} + \alpha M{\mathit{\boldsymbol{I}}_{\rm{t}}} $ | (7) |

| $ {\sigma _t}^2 = \left( {1-\alpha } \right)M{\sigma _{t-1}}^2 + M\alpha {({\mathit{\boldsymbol{I}}_t}-\mathit{\boldsymbol{\mu }}{\rm{ }})^{\rm{T}}}\alpha ({\mathit{\boldsymbol{I}}_t} - \mathit{\boldsymbol{\mu }}) $ | (8) |

| $ {\omega _{i, t}} = \left( {1-\alpha } \right){\omega _{i, t-1}} + \alpha M $ | (9) |

式中:α为权值的学习速率; M为背景掩膜, 在背景匹配的区域内取1, 其余取0。

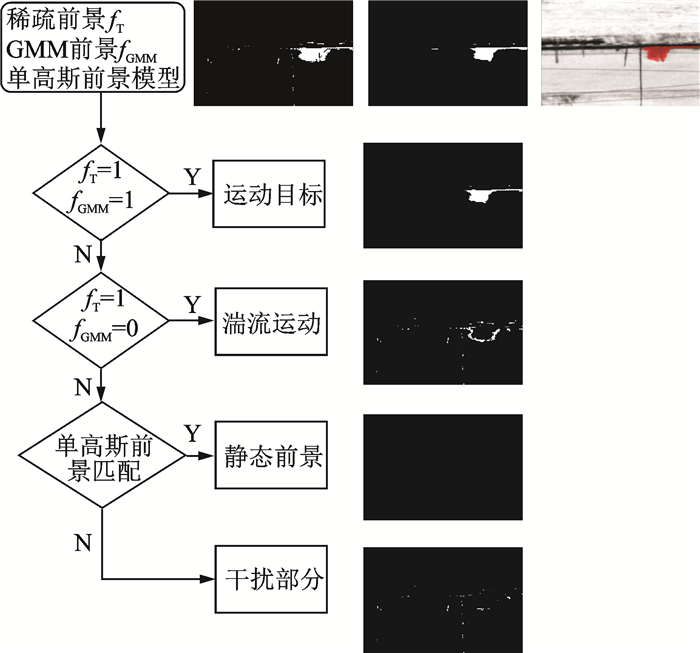

2.3 检测区域的融合判定基于阈值分割的目标提取计算简单, 但由于分割是在稀疏部分基础上进行, 受到湍流运动的稀疏性影响, 容易存在误检测问题; 基于背景减除的前景检测法能够获得空间连续的结果, 但对噪声敏感。为获得更准确、更完整的目标区域, 对两部分检测区域进行融合判定。将2.1节中结果记作fT(x, y, t), 表示第t帧(x, y)处为前景的布尔值; 将2.2节中混合高斯检测结果记作fGMM(x, y, t), 采用融合规则对检测结果进行判定。具体如下。

(1) 同时被稀疏的阈值分割和低秩的GMM背景减除而提取的前景区域, 判定为运动目标, 并记为fmoving, 即

| $ {f_{{\rm{moving}}}}\left( {x, y, t} \right) = \left\{ \begin{array}{l} 1\;\;\;\;\;{f_{\rm{T}}}\left( {x, y, t} \right) = 1\;{且}\;{f_{{\rm{GMM}}}}\left( {x, y, t} \right) = 1\\ 0\;\;\;\;\;{其他} \end{array} \right. $ | (10) |

(2) 稀疏阈值分割检测为前景, 但低秩背景减除检测为背景的区域, 往往是稀疏的湍流和噪声量, 判定为干扰部分。

(3) 对于混合高斯减除判定为前景, 但稀疏阈值检测为非前景, 此类区域可能是运动状态发生改变(如暂时停止或由于运动而露出的背景), 属于疑似前景, 记为famb。对疑似区域进行前景判定, 式(6)改写为

| $ {f_{{\rm{static}}}}\left( {x, y, t} \right) = \left\{ \begin{array}{l} 1\;\;\;\;\;\;\;\;\;\;\;{f_{{\rm{a}}{\rm{m}}{\rm{b}}}}\left( {x, y, t} \right) = 1{\rm{ and}}\;\left| {{I_t}\left( {x, y} \right)-{\mu _t}} \right|/{\sigma _t} > {T_{\rm{f}}}\\ 0\;\;\;\;\;\;\;\;\;\;{其他} \end{array} \right. $ | (11) |

式中Tf用于决定前景的阈值。为使最终获得的目标尽量无噪点干扰, 在不影响查全率的前提下对处理后的结果作适当的区域滤波。图 3为一帧图像融合判定的全过程。最终判定该输入帧中有一行驶车辆(运动目标)和湍流噪声干扰, 不存在静态目标。

|

图 3 融合分裂高斯建模和稀疏阈值的前景检测 Fig. 3 Fusion of split Gaussian models and threshold segmentation |

3 实验结果及分析 3.1 实验设置和结果

为验证本文方法的有效性, 在软硬件环境为双Pentium(R) Dual-Core 2.1 GHz CPU, RAM 8 GB, Matlab 2010a的条件下编程实验。实验数据选取3组远距离拍摄(5~15 km)的红外湍流退化图像, 每帧分辨率均为360×240, 不同序列涵盖了目标提取的不同情况, 具体如下:

序列1:序列共2 200帧, 记录了道路上车辆和行人通行的情景。其中出现多辆大小不等的车辆, 存在车辆遮挡、快速行驶等现象。

序列2:序列共1 300帧, 记录了山林中车辆行驶的场景。其中存在一车辆减速行驶, 在第300帧到380帧时呈静止态, 后缓慢加速至驶离场景的情况。

序列3:序列共1 200帧, 记录了单个船只在河流中直线行驶的场景。受较强大气湍流影响, 视频序列全程场景呈现严重模糊和连续抖动。此外, 背景中部分水域随时间推移发生灰度缓慢变化。

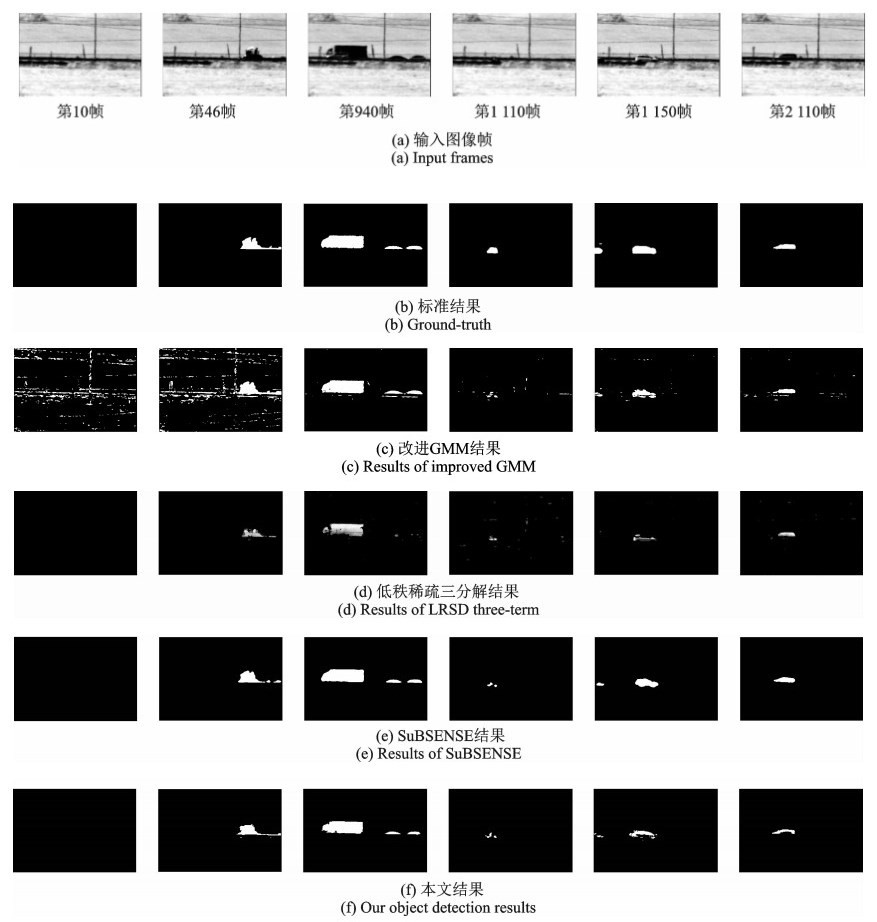

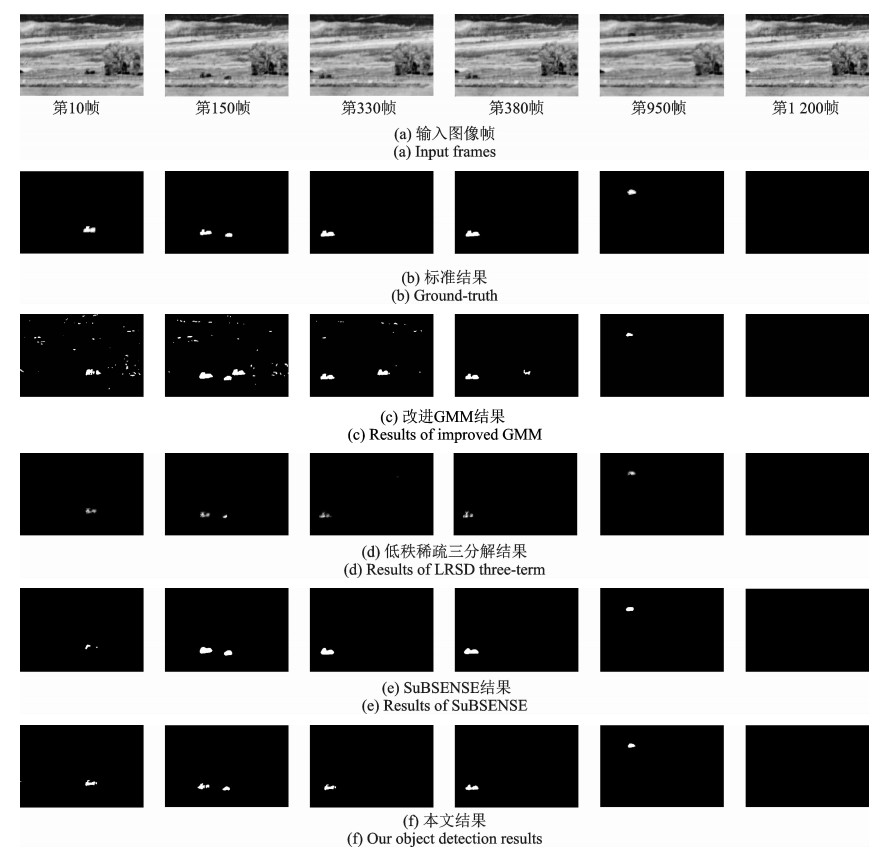

在相同实验环境下, 选取改进的混合高斯建模法[12]、低秩稀疏三分解法(Low-rank and sparse three-term decomposition, LRSD Three-term)[18]和近期最具竞争力的SuBSENSE法[21]与本文方法进行对比。为获得尽可能稳定的场景和完整的目标, 避免过度平滑, 本文方法在分解时按经验设置正则参数。考虑到湍流强度的不同, 序列1和序列2中正则参数γ设为20, 序列3中设为5.0。采用IALM法求解低秩模型, 设迭代允许误差ε=10-3, 最大迭代次数为1 000。混合高斯模型的学习速率根据经验值设为0.004。为以适应快速变化的前景, 单高斯模型的学习速率设置较高值, 其他算法均默认其参数设置。鉴于页面所限, 每组序列仅列出部分帧和对应的ground-truth, 各算法的检测结果如图 4~6所示。

|

图 4 序列1中目标检测的实验结果对比 Fig. 4 Object detection results on sample frames from Sequence 1 |

|

图 5 序列2中目标检测的实验结果对比 Fig. 5 Object detection results on sample frames from Sequence 2 |

|

图 6 序列3中目标检测的实验结果对比 Fig. 6 Object detection results on sample frames from Sequence 3 |

在轻微湍流情况下(图 4和图 5), 由于湍流的存在使整个场景呈现不规则抖动, GMM初始化背景模型时选择的是初始一段时间内的连续帧, 使得背景建模不能适应整体抖动, 提取的前景中包含有许多受湍流偏移干扰的微小区域, 如图 4(c)。对于初始就存在运动目标的情况, 目标驶离使得原位置中被暴露的背景被误检为目标, 如图 5(c)。随着背景模型的适应更新, 误检区域逐渐消失, 改进GMM方法能够较好地实现目标主要区域的检测。LRSD Three-term法通过计算湍流运动和直线运动的不同分布, 设置置信度阈值来提取目标区域, 在小目标检测时能获得较好的结果, 如图 5(d); 当目标较大时极易出现空洞和漏检, 如图 4(d)。在背景变化比较平稳时, SuBSENSE法能够精准地提取目标区域, 如图 4(e)和图 5(e)。本文方法通过低秩分解并融合背景减除和前景稀疏的特点, 能够去除湍流抖动所产生的干扰, 同时需要注意, 由于采用稀疏的阈值分割和融合的“并”规则, 不能足够精确区分与背景灰度相似的前景区域, 使得检测结果中发生了部分漏检的现象, 如图 4(f)中道路和小车底部区域较为相似而出现漏检。

图 6所处的远距离场景受强湍流影响, 且右方一块水域亮度随时间推移发生变化, 导致GMM法在背景减除时结果出现较大误差。低秩三分解法在强湍流下几乎不能检测出目标。SuBSENSE法和本文方法对于模糊图像有较强的适应能力, 虽存在少量误检, 检测结果仍接近ground-truth。

3.2 量化分析为更清晰地对比4种算法的检测性能, 文中分别统计了每组序列中被正确标记的前景像素点数(True positive, TP)、被正确标记的背景像素点数(True negative, TN)、被错误标记为前景的背景像素点数(False positive, FP)和被错误标记为背景的前景像素点数(False negative, FN)。选取误检率(False positive rate, FPR)、漏检率(False negative rate, FNR)和F-measure来衡量目标区域提取效果的优劣。

| $ \begin{array}{l} {\rm{FPR = }}\frac{{{\rm{FP}}}}{{{\rm{TP + FP}}}}{\rm{, FNR = }}\frac{{{\rm{FN}}}}{{{\rm{TP + FN}}}}\\ {\rm{F-Measure}} = \frac{{2*{\rm{Precision}}*{\rm{Recall}}}}{{{\rm{Precision + Recall}}}}\\ {\rm{Recall}} = \frac{{{\rm{TP}}}}{{{\rm{TP + FN}}}}{\rm{, Precision = }}\frac{{{\rm{TP}}}}{{{\rm{TP + FP}}}} \end{array} $ |

式中:Recall和Precision分别为查全率和查准率; F-measure是这两者的调和平均, 用于综合反映整体性能。

表 1给出了不同算法检测性能的对比结果。由表 1可以看出, 对于序列1和序列2, SuBSENSE法和本文方法得到的误检率明显低于GMM方法和LRSD Three-Term方法。改进GMM方法的漏检率较低, 但误检率也远远高于其他算法, 目标提取的精准程度一般。对于序列3而言, 本文方法取得了较低的误检率和较高的F-Measure值, 目标提取的性能优于其他3种方法。本文方法不仅可以较好地去除湍流的偏移抖动对背景减除带来的干扰, 而且能很好地解决LRSD Three-Term方法提取较大目标时漏检率高的问题。实验证明了本文方法的有效性。

| 表 1 不同方法检测结果的性能对比 Tab. 1 Performance comparison of several object detection approaches |

4 结束语

本文针对湍流退化序列图像中目标检测的问题, 提出了一种基于低秩分解和检测融合的目标提取方法。首先, 采用低秩矩阵描述法将图像分解为低秩稳像和稀疏运动两部分, 初步实现场景和湍流运动的粗分离; 然后, 对稀疏部分引入自适应阈值法剔除干扰量, 分割目标并填补其中空洞; 并对低秩部分采用高斯建模获得低秩中的前景区域; 最后, 对两部分检测结果联合判定以获得准确的目标检测结果。该方法有以下特点:(1)采用低秩稀疏描述对湍流序列建模, 可将稳像场景和稀疏运动区分开。(2)较之传统的检测方法, 本文算法在分解时的时间消耗较短。此外, 通过联合决策提取准确的目标区域, 最终检测的准确率较其他方法提高明显。实验结果证明了本文方法的有效性和优越性。如何从动态场景中准确提取目标物体, 并对其进行跟踪和识别是下一步研究的重难点。

| [1] |

殷兴良. 气动光学原理[M]. 北京: 中国宇航出版社, 2003: 169-173. Yin Xingliang. Principle of aero-optics[M]. Beijing: China Astronautics Press, 2003: 169-173. |

| [2] |

Roggemann M C, Welsh B M, Hunt B R. Imaging through turbulence[M]. Boca Raton: CRC Press, 1996.

|

| [3] |

Brox T, Malik J. Large displacement optical flow:Descriptor matching in variational motion estimation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(3): 500-513. DOI:10.1109/TPAMI.2010.143 |

| [4] |

储林臻, 闫钧华, 杭谊青, 等. 基于改进光流法的旋转运动背景下对地运动目标实时检测[J]. 数据采集与处理, 2015, 30(6): 1325-1331. Chu Linzhen, Yan Junhua, Hang Yiqing, et al. Real-time ground moving object detection in rotational background based on improved optical flow method[J]. Journal of Data Acquisition and Processing, 2015, 30(6): 1325-1331. |

| [5] |

Bunyak F, Palaniappan K, Nath S K, et al. Flux tensor constrained geodesic active contours with sensor fusion for persistent object tracking[J]. Journal of Multimedia, 2007, 2(4): 20. |

| [6] |

Lipton A, Kanade T, Fujiyoshi H, et al. A system for video surveillance and monitoring[M]. Pittsburg: Carnegie Mellon University, the Robotics Institute, 2000.

|

| [7] |

Brutzer S, Höferlin B, Heidemann G. Evaluation of background subtraction techniques for video surveillance[C]//IEEE Conference on ComputerVision and Pattern Recognition. Florida: IEEE, 2011: 1937-1944.

|

| [8] |

Sobral A, Vacavant A. A comprehensive review of background subtraction algorithms evaluated with synthetic and real videos[J]. Computer Vision and Image Understanding, 2014, 122: 4-21. DOI:10.1016/j.cviu.2013.12.005 |

| [9] |

Stauffer C, Grimson W E L. Adaptive background mixture models for real-time tracking[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Fort Collins: IEEE, 1999, 2: 246-252.

|

| [10] |

Zivkovic Z, van der Heijden F. Efficient adaptive density estimation per image pixel for the task of background subtraction[J]. Pattern Recognition Letters, 2006, 27(7): 773-780. DOI:10.1016/j.patrec.2005.11.005 |

| [11] |

Chen Z, Ellis T. A self-adaptive Gaussian mixture model[J]. Computer Vision and Image Understanding, 2014, 122: 35-46. DOI:10.1016/j.cviu.2014.01.004 |

| [12] |

Gal R, Kiryati N, Sochen N. Progress in the restoration of image sequences degraded by atmospheric turbulence[J]. Pattern Recognition Letters, 2014, 48: 8-14. DOI:10.1016/j.patrec.2014.04.007 |

| [13] |

卢晓芬, 张天序, 洪汉玉. 气动光学效应像素偏移图像校正方法研究[J]. 红外与激光工程, 2007, 36(5): 758-761. Lu Xiaofen, Zhang Tianxu, Hong Hanyu. Image correction method with pixel deviation caused by aero-optics effects[J]. Infrared and Laser Engineering, 2007, 36(5): 758-761. |

| [14] |

李轶南, 贾冲, 杨吉斌, 等. 稀疏低秩模型下的单通道自学习语音增强算法[J]. 数据采集与处理, 2014, 29(2): 286-292. Li Yinan, Jia Chong, Yang Jibin, et al. Self-learning approach for monaural speech enhancement based on sparse and low-rank matrix decomposition[J]. Journal of Data Acquisition and Processing, 2014, 29(2): 286-292. |

| [15] |

Ma R, Barzigar N, Roozgard A, et al. Decomposition approach for low-rank matrix completion and its applications[J]. IEEE Transactions on Signal Processing, 2014, 62(7): 1671-1683. DOI:10.1109/TSP.2014.2301139 |

| [16] |

Ji H, Huang S, Shen Z, et al. Robust video restoration by joint sparse and low rank matrix approximation[J]. SIAM Journal on Imaging Sciences, 2011, 4(4): 1122-1142. DOI:10.1137/100817206 |

| [17] |

何玉杰, 李敏, 张金利, 等. 基于低秩三分解的红外图像杂波抑制[J]. 光学精密工程, 2015, 23(7): 2069-2078. He Yujie, Li Min, Zhang Jinli, et al. Clutter suppression of infrared image based on three-component low-rank matrix decomposition[J]. Optics and Precision Engineering, 2015, 23(7): 2069-2078. |

| [18] |

Oreifej O, Li X, Shah M. Simultaneous video stabilization and moving object detection in turbulence[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(2): 450-462. DOI:10.1109/TPAMI.2012.97 |

| [19] |

Candès E J, Li X, Ma Y, et al. Robust principal component analysis[J]. Journal of the ACM, 2011, 58(3): 11. |

| [20] |

张姣, 李俊山, 李成, 等. 低秩稀疏分解下的湍流退化图像序列盲去卷积算法[J]. 光电子·激光, 2015, 26(7): 1373-1379. Zhang Jiao, Li Junshan, Li Cheng, et al. A multi-frame blind deconvolution algorithm based on low-rank decomposition for turbulence-degraded images[J]. Journal of Optoelectronics Laser, 2015, 26(7): 1373-1379. |

| [21] |

St-Charles P L, Bilodeau G A, Bergevin R. SuBSENSE:A universal change detection method with local adaptive sensitivity[J]. IEEE Transactions on Image Processing, 2015, 24(1): 359-373. DOI:10.1109/TIP.2014.2378053 |

2018, Vol. 33

2018, Vol. 33